Main findings

Medical responses from an AI language model were perceived as more empathetic, informative and helpful compared to responses from doctors.

Several studies have examined how artificial intelligence (AI) responds to health-related questions. Generative Pre-training Transformer (GPT) is an AI model that can understand and generate human language. A US study published in 2023 found that answers generated by the GPT-3.5 language model to health-related questions in English were perceived as more empathetic and informative than answers from doctors (1). How AI responses are perceived could have significant implications and great potential value for the healthcare sector.

Since language, culture and medical guidelines vary between countries, we wanted to investigate how those with a background in health care in Norway perceive responses from large language models to health-related questions, compared to answers from doctors. We also examined whether the responses were evaluated differently by doctors and licensed medical students, compared to those with other backgrounds in health care.

Material and method

A total of 192 health-related questions and corresponding answers from doctors, sourced from the website Studenterspør.no, were included in the study. Studenterspør.no is a platform where students can submit questions and receive answers from healthcare personnel. The responses are published anonymously. We developed a script to retrieve questions and answers from the category 'Body, sex and identity' and the subcategory 'Illness and symptoms'. This category was chosen because it contains a wide range of health-related questions and a high proportion of answers provided by doctors.

We developed a set of instructions for GPT-4 to ensure that the model's responses adhered to the desired format, length, content and language. It was emphasised that the responses from GPT-4, like those from Studenterspør.no, should not be regarded as medical assistance, in accordance with the Health Personnel Act (2). Instead, they were to serve as health-related guidance and advice, as opposed to replacing medical advice from healthcare personnel. The instructions were developed iteratively until GPT-4 produced satisfactory answers to a set of test questions. The instruction set was then locked, and the same instructions were applied to all the questions in the study. The results were analysed using Python.

Respondents were recruited from email lists for emergency care, nursing homes and hospital departments, at stands and via posters at Haukeland University Hospital, Facebook groups for healthcare personnel and directly through contacts within the health service. Doctors, licensed medical students, and those working, studying or with a background in health care were included in the study. Data were collected from the participating 344 respondents in the period 15 January to 18 February 2024.

The survey was distributed via a customised web application where respondents could read one question with two corresponding answers at a time, and provide their rating for each of the different dimensions. The application included information about data protection and definitions of the evaluation criteria. Participants were informed that one answer was generated by GPT-4 and one was written by a doctor, but they were not told which was which. The questions were assigned randomly. Respondents evaluated the empathy, quality of information and helpfulness of the answers based on a five-point Likert scale. For quality of information, it was also possible to answer 'Don't know'. Respondents could skip questions, and the survey could be completed after evaluating five questions, or earlier if desired. The survey could be taken multiple times.

Detailed information about the inclusion of questions, answer generation, definitions of the evaluation terms, analysis and results, as well as complete instructions and examples of questions and answers, is available here: https://github.com/MMIV-ML/helseveileder.

Results

A total of 344 respondents evaluated the 192 questions, providing a total of 1109 ratings of question-answer sets. The average number of ratings per answer was 5.7 (standard deviation 6.7), with a median of 5. Nineteen respondents (5.4 %) participated in the study more than once. Among the respondents, 44 (12.8 %) were doctors or licensed medical students, while 300 (87.2 %) were not doctors or licensed medical students but were studying, working or had a background in health care.

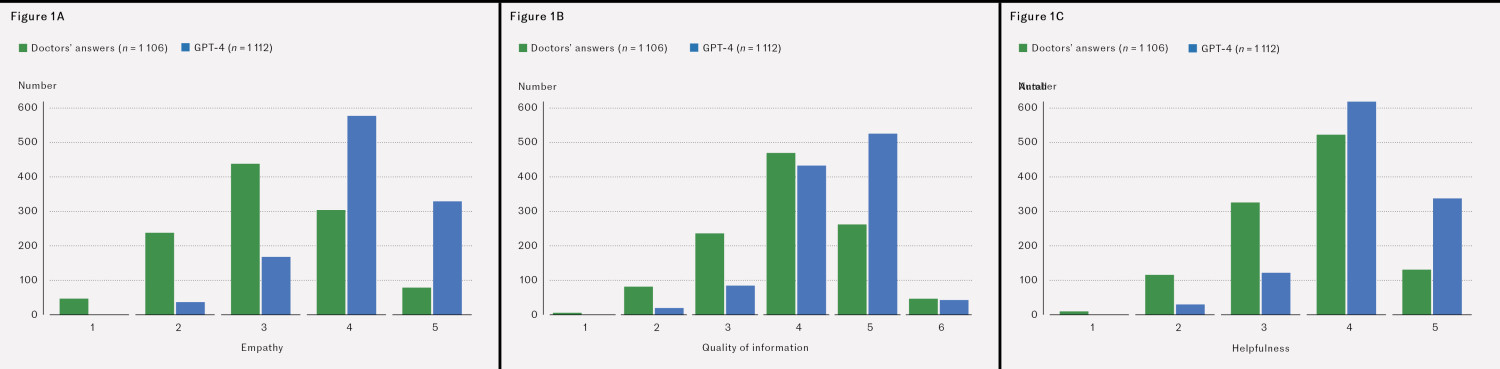

Figure 1 shows respondents' ratings of empathy, quality of information and helpfulness. Note the shift toward higher scores for GPT-4 responses across all three dimensions. Empathy: χ2 = 571.26, df =4, p < 0.001, quality of information: χ2 = 204.24, df =4, p < 0.001 and helpfulness: χ2 = 258.49, df =4, p < 0.001.

Discussion

GPT-4-generated responses to health-related questions were considered more empathetic, informative and helpful than those from doctors. Our findings indicate that the doctors and licensed medical students did not assess quality of information differently to other respondents who work, study or have a background in health care.

The findings of our study align with the results of a previously published study (1), and the value of large language models has also been demonstrated in other studies. For example, preliminary, non-peer-reviewed findings suggest that responses generated by language models may offer improved diagnostic accuracy and conversational quality (3), or that language model responses to questions about anaesthesia care are of the same quality as the content in academic sources (4). These examples demonstrate that AI can provide answers that are as good as, and sometimes better than, those of doctors, indicating that AI can be a valuable tool.

However, other studies report conflicting findings. One study found that doctors who answered electronic patient enquiries using GPT-4-generated draft replies spent more time reading and editing the drafts and did not save any time completing their responses (5). The study also showed that the doctors' responses became longer. This highlights the importance of further investigation into how integrating this form of AI can actually improve health care and aid healthcare personnel.

Unlike the 2023 study (1), we used GPT-4 instead of the older GPT-3.5 and developed customised instructions for the model. In addition to empathy and quality of information, this study also examined perceptions of the helpfulness of doctors' and GPT-4s' answers. All respondents were blinded to whether the responses they evaluated were written by doctors or generated by the language model. Our instructions were designed to make it difficult to identify whether a response was AI-generated. Unlike previous studies, none of the respondents in this study were involved in its design or publication.

One limitation of our study is that respondents may have recognised the language model's responses, which could introduce confirmation bias based on their attitudes to AI. We chose not to ask respondents to identify the source of the responses to avoid drawing attention to this. However, a limitation of our study is that we cannot assess the extent to which they recognised the source or how this may have affected the results.

There may also be selection bias if individuals with strong positive or negative views are overrepresented while those with more neutral attitudes are underrepresented.

Respondents self-reported whether they were doctors or licensed medical students, without verification against the health personnel registry. Collecting additional information from respondents would have allowed us to examine the impact of factors such as work experience and occupation.

Conclusion

The study shows that responses to health-related questions generated by the language model GPT-4 were rated as more empathetic, informative and helpful than those from doctors. This suggests that AI could serve as an aid for healthcare personnel by generating high-quality draft responses to health-related questions.

We would like to thank Studenterspør.no for their cooperation and for allowing us to use questions and answers from their website.

The article has been peer-reviewed.

- 1.

Ayers JW, Poliak A, Dredze M et al. Comparing physician and artificial intelligence chatbot responses to patient questions posted to a public social media forum. JAMA Intern Med 2023; 183: 589–96. [PubMed][CrossRef]

- 2.

Helse- og omsorgsdepartementet. LOV-1999-07-02-64. Lov om helsepersonell m.v. (helsepersonelloven). https://lovdata.no/dokument/NL/lov/1999-07-02-64 Accessed 10.10.2024.

- 3.

Tu T, Palepu A, Schaekermann M et al. Towards conversational diagnostic AI. arXivorg. Preprint 11.1.2024. https://arxiv.org/abs/2401.05654 Accessed 13.10.2024.

- 4.

Segal S, Saha AK, Khanna AK. Appropriateness of answers to common preanesthesia patient questions composed by the large language model GPT-4 compared to human authors. Anesthesiology 2024; 140: 333–5. [PubMed][CrossRef]

- 5.

Tai-Seale M, Baxter SL, Vaida F et al. AI-Generated draft replies integrated into health records and physicians' electronic communication. JAMA Netw Open 2024; 7. doi: 10.1001/jamanetworkopen.2024.6565. [PubMed][CrossRef]

I en nylig publisert studie i Tidsskrift for Den norske legeforening undersøker medisinstudentene Mork og Mjøs, sammen med sine medforfattere, hvordan kunstig intelligens (KI) svarer på helsespørsmål (1). Studien viser et flott initiativ og en god forståelse for den vitenskapelige metode, særlig ved at de bygger videre på et eksisterende datasett og gjør metodikken sin tilgjengelig via GitHub.

En av de mest interessante aspektene ved studien er tilgangen de har valgt. Ved å bruke et allerede eksisterende datasett, får de mulighet til å analysere store mengder informasjon uten å måtte konstruere et nytt eksperiment fra bunnen av. Dette er en metodisk styrke, men det er også viktig å reflektere over hvem som vurderer svarene KI gir – og hvilken ekspertise disse vurderingene baserer seg på.

Studien baserer seg på vurderinger fra 344 respondenter, men av disse var kun 44 leger eller medisinstudenter. Det innebærer at nesten 90 % av respondentene ikke hadde medisinsk utdanning. Dette reiser et viktig spørsmål: Ville resultatene vært annerledes dersom en større andel av vurderingene kom fra medisinsk kvalifiserte personer?

Leger har en spesialisert kunnskap om diagnostikk, sykdomsforløp og behandlingsalternativer, noe som kan gjøre dem bedre i stand til å vurdere nøyaktigheten og nytteverdien av KI-genererte svar. En interessant oppfølgingsanalyse kunne derfor vært å se på hvordan vurderingene fra leger skiller seg fra de øvrige respondentene. Er det for eksempel slik at leger vurderer KI-svarene som mer eller mindre presise enn lekfolk gjør? Opplever de at KI i større grad gir plausible, men potensielt misvisende svar?

Dersom det viser seg at leger vurderer KI-svarene annerledes enn den generelle befolkningen, kan dette ha flere konsekvenser. Det kan tyde på at ikke-eksperter har en annen oppfatning av hva som utgjør et godt helseråd, noe som kan påvirke hvordan pasienter forholder seg til KI-baserte verktøy. Det kan også indikere at fremtidige evalueringer av slike systemer bør inneholde en tydeligere medisinsk ekspertkomponent for å sikre faglig kvalitet.

Studien av Mork og Mjøs er et viktig bidrag til diskusjonen om KI i helsetjenesten, men den reiser også nye spørsmål som bør utforskes videre. En mer detaljert analyse av vurderingene fra leger kontra ikke-leger kunne vært et naturlig neste steg.

Litteratur

1. Mork TE, Mjøs HG, Nilsen HG et al. Kunstig intelligens og legers svar på helsespørsmål. Tidsskr Nor Legeforen 2025; 145. doi: 10.4045/tidsskr.24.0402

Artikkelen «Kunstig intelligens og legers svar på helsespørsmål» konkluderer (1):

Svarene generert av GPT-4 ble vurdert som mer empatiske, kunnskapsrike og hjelpsomme enn svarene fra leger. Det antyder at kunstig intelligens kan avlaste helsepersonell ved å formulere gode svarutkast på helsespørsmål.

Det er ikke overraskende at kunstig intelligens (KI) kan gi gode svar på gode spørsmål. Resultatene kan imidlertid ikke sees i isolasjon, og gjør det betimelig å minne om risiko ved bruk av ChatGPT eller lignende KI-modeller i klinisk medisinsk praksis.

1. Unøyaktighet og feilinformasjon – KI-modeller kan generere uriktige eller utdaterte medisinske råd, som kan føre til skadelige kliniske beslutninger.

2. Mangel på klinisk skjønn – KI mangler menneskelig intuisjon og profesjonell erfaring, som er avgjørende i komplekse saker som krever nyanserte vurderinger.

3. Skjevhet og etiske bekymringer – KI-modeller trenes på store datasett som kan inneholde skjevheter. Dette kan føre til ulikheter i medisinske anbefalinger, spesielt for underrepresenterte pasientgrupper.

4. Personvern og datasikkerhet – Bruk av KI i pasientinteraksjoner medfører risiko for eksponering av sensitiv helseinformasjon.

5. Juridiske og ansvarsmessige spørsmål – Det er uklart hvem som har ansvaret dersom KI-baserte råd fører til pasientskade – helsepersonell, institusjoner eller KI-utviklere.

6. Overavhengighet av KI – Klinikerne kan bli for avhengige av KI-forslag, noe som kan svekke deres kritiske tenkning og diagnostiske ferdigheter.

7. Mangel på forklarbarhet – KI-modeller fungerer som "svarte bokser". Dette gjør det vanskelig å forstå hvordan de kommer frem til konklusjoner, og skaper utfordringer med åpenhet og tillit.

8. Regulatoriske utfordringer – Nåværende medisinske reguleringer dekker ikke fullt ut KI-integrasjon i klinisk arbeidsflyt.

9. Feilinformasjon til pasienter – Dersom pasienter bruker KI-genererte medisinske råd uten profesjonell oppfølging, kan de feiltolke anbefalingene, utsette nødvendig behandling eller stille feil selvdiagnoser.

Rådet for legeetikk behandlet i 2024 en klage på et legesenters oppfordring til pasienter om bruk av ChatGPT som forberedelse til legetimer. Rådets vurdering var at dette representerte brudd på Etiske regler for leger kapittel I §§ 4 og 9, da ChatGPT ikke er en medisinsk anerkjent metode. Den medisinskfaglige kompetansen ligger hos legen, og kan ikke delegeres til pasientene. Legesenteret har ikke kontroll med kommunikasjonen mellom pasienten og ChatGPT – inkludert viktige aspekter som hvordan OpenAI bruker informasjonen pasienten legger inn, og risikoen for feilinformasjon. Rådet anbefalte innklagede å slutte med å anbefale pasienter å bruke ChatGPT for å forberede seg til legebesøk.

Det nevnes at helsemyndighetene maner til forsiktighet (2).

En opplyst diskusjon om hvordan KI skal brukes på en trygg måte i legenes kliniske virke, og for pasientene, blir avgjørende. Rådet ønsker en debatt om ovennevnte problemstillinger velkommen.

Litteratur:

1. Mork TE, Mjøs HG, Giskegjerde H et al. Kunstig intelligens og legers svar på helsespørsmål. Tidsskr Nor Legeforen 2025; 145. doi: 10.4045/tidsskr.24.0402

2. Dobloug HM. Kunstig intelligens i allmennpraksis: Kjøreregler for trygg og lovlig bruk. Dagens Medisin 6.12.2024. https://www.dagensmedisin.no/digitalisering-fastlegeordningen-fastleger/kunstig-intelligens-i-allmennpraksis-kjoreregler-for-trygg-og-lovlig-bruk/665298 Lest 22.2.2025.

Vi takker Damoun Nassehi for hans kommentar (1) og engasjement i diskusjonen om hvordan kunstig intelligens (KI) svarer på helsespørsmål.

Vi ønsker likevel å presisere en detalj i hans innlegg: Antallet medisinstudenter som vurderte svarene, var høyere enn det han oppgir. Blant respondentene var 44 medisinstudenter med lisens eller leger, men i tillegg deltok en rekke respondenter med annen helsefaglig bakgrunn. En stor andel av disse var medisinstudenter uten lisens, selv om vi ikke har ført detaljert statistikk over deres bakgrunn. Når vi sammenlignet evalueringene fra leger og medisinstudenter med lisens med personer med annen helsefaglig bakgrunn, fant vi imidlertid ingen forskjeller (2).

Studiens resultater må naturligvis tolkes i lys av hvilken medisinsk kompetanse som vurderer KI-genererte svar, og dette er et viktig spørsmål for videre forskning. Oppdager leger nyanser eller svakheter i KI-genererte svar som andre ikke ser? Uansett er det en risiko for at KI-genererte svar sprer feilinformasjon som ved første øyekast kan fremstå troverdig.

Hensikten med vår studie er ikke å anbefale at pasienter bruker KI i stedet for å kontakte lege, eller at helsevesenet skal basere seg på KI-svar som ikke signeres eller kvalitetssikres av lege. Vårt mål er å bidra til et kunnskapsgrunnlag for hvordan KI besvarer medisinske spørsmål fra pasienter, og hvordan KI potensielt kan brukes til å støtte leger i en travel arbeidshverdag — for eksempel ved å utforme svarutkast som kan gi pasientene bedre og mer empatiske tilbakemeldinger.

Litteratur

1. Nassehi D. Hvem bør vurdere kunstig intelligens’ medisinske råd? Tidsskr Nor Legeforen 19.2.2025. https://tidsskriftet.no/2025/02/kommentar/hvem-bor-vurdere-kunstig-intelligens-medisinske-rad#comment-3413 Lest 12.3.2025.

2. Mork TE, Mjøs HE, Nilsen HG et al. Kunstig intelligens og legers svar på helsespørsmål. Tidsskr Nor Legeforen 2025; 145. doi: 10.4045/tidsskr.24.0402